Bonjour monsieurs,

C'est une curiosité, mais j'aimerais savoir pourquoi l'entropie d'une source (var. aléatoire) X est définie par la somme de -log (pi)*pi (pourquoi le logarithme?).

En effet, je comprends bien l'inégalité présentée dans le livre d'Introduction au Numérique, soit 0 < H < log (n), par l'intermédiaire de l'inégalité de Jensen pour des fonctions concaves et convexes, et la raison pour laquelle on passe par le long en base 2 quand il s'agit des bits.

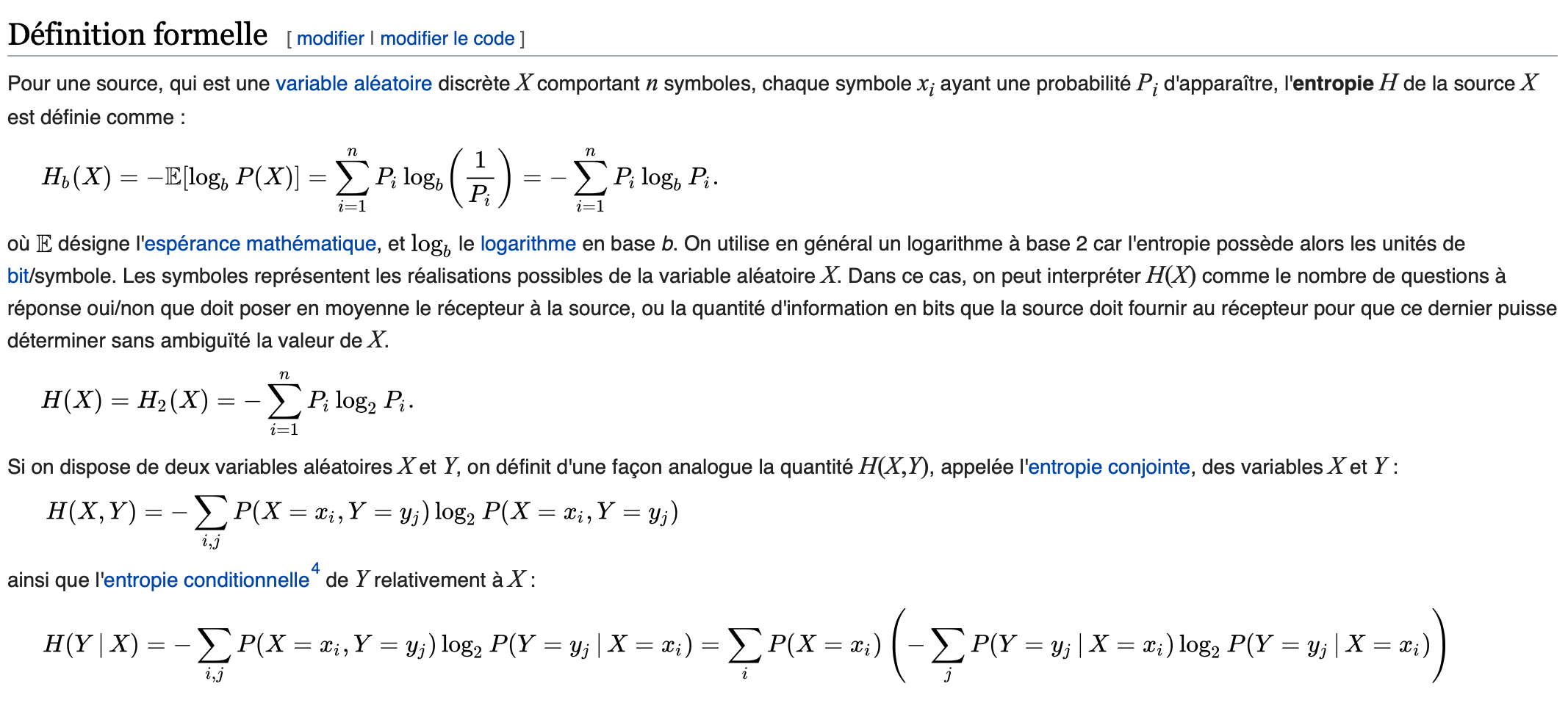

Néanmoins, j'ai voulu me renseigner à propos de la formule pour l'entropie de Shannon (je joins une photo), et je ne comprends pourquoi on choisit la fonction log x ou d'où elle sort (empiriquement?).

Très cordialement,